MiniMax: MiniMax M2.5 | Чат-бот

Бесплатный доступ к нейросети, без регистрацииДоступ к топовым нейросетям

- ✨ Нет ограничения на количество символов

- ✨ Бонус за регистрацию

- ✨ Все передовые нейросети в одном месте

- ✨ Удобные чат-боты в Telegram и VK

История создания: от идеи до реализации

Давайте начистоту: идея MiniMax M2 родилась не на пустом месте. Это был, по сути, ответ на безумную гонку вооружений в мире больших языковых моделей, где все гнались за триллионами параметров, делая свои нейросети всё более дорогими и неповоротливыми. Команда из китайского стартапа MiniMax, кажется, посмотрела на всё это и задалась простым вопросом: а что, если пойти другим путём? Что, если вместо одного гигантского «всезнайки» собрать эффективную команду узких специалистов?

Так и появилась на свет архитектура Mixture of Experts (MoE) в их исполнении. Представьте себе: у вас есть огромный «мозг» на 230 миллиардов параметров, но для решения конкретной задачи, будь то написание кода или анализ данных, вы активируете только нужную «бригаду экспертов» — всего около 10 миллиардов. И вот тут-то и кроется вся магия. Модель получилась не просто мощной, а невероятно экономичной. Она не пытается быть громоздким швейцарским ножом, а действует как слаженный отряд спецназа — быстро, точно и без лишних затрат. Именно этот подход позволил ей обойти по эффективности конкурентов, которые в семь раз крупнее.

Что может MiniMax M2.5: возможности и преимущества

Так в чем же фишка MiniMax-M2? А в том, что это не просто очередной гига-модель, которая пытается решить все задачи грубой силой. Вся соль в её архитектуре Mixture of Experts (MoE). Представьте себе: у модели 230 миллиардов общих параметров, но на каждый ваш запрос она задействует всего-то около 10 миллиардов. Это как иметь огромный штат специалистов, но вызывать только нужного эксперта для конкретной задачи. В результате — и скорость выше, и затраты ниже. По сути, MiniMax-M2 превосходит по эффективности модели, которые в 7 раз крупнее, и это меняет правила игры.

И вот эта экономичность открывает дорогу к самому интересному — агентским задачам. MiniMax-M2 — это не просто болталка, это настоящий цифровой «стажёр». Он буквально «думает вслух» в специальных тегах <think>, показывая свою логику, прежде чем выдать ответ. И что он умеет? Да почти всё, что нужно младшему разработчику:

- Написать код на Python или JS.

- Запустить его, увидеть ошибку и тут же её исправить.

- Поработать с терминалом или погуглить инфу в браузере.

Это уже не генерация текста, а полноценный рабочий процесс. Именно это отличает его от многих конкурентов, которые крупнее, но, по факту, не такие уж и расторопные.

Сравнение с конкурентами: чем MiniMax M2.5 лучше?

Давайте начистоту: когда речь заходит о сравнении моделей, мы привыкли видеть чёткое разделение. Есть закрытые гиганты вроде GPT-4 и Claude 3 Opus — мощные, но дорогие и недоступные для кастомизации. А есть open-source, который, ну, обычно на шаг позади. Так вот, MiniMax M2 (или M2.5, как её иногда называют) ломает этот шаблон. Она не просто «хорошая для открытой модели», она на равных борется с топовыми проприетарными системами в самых сложных задачах, вроде агентского использования и написания кода.

И вот тут-то и кроется вся магия, которую не видно в сухих цифрах бенчмарков. Дело в том, как она это делает. Благодаря архитектуре Mixture of Experts, из своих 230 миллиардов параметров для решения вашей задачи она активирует всего около 10 миллиардов. Вдумайтесь: вы получаете интеллект уровня самых «тяжёлых» моделей, но с вычислительными затратами, которые в разы ниже. Это как если бы болид Формулы-1 расходовал топливо как городской хэтчбек.

Что это значит на практике? А то, что теперь для создания по-настоящему умного ИИ-агента, который может сам исправлять свой код или работать с файлами, не нужна инфраструктура Google. Это делает передовые технологии доступными для небольших команд и даже энтузиастов-одиночек. MiniMax — это не просто ещё одна строчка в рейтинге, это реальный шаг к демократизации мощного ИИ.

Как это работает: простыми словами о сложной архитектуре

В чём же фишка архитектуры MiniMax-M2? Всё дело в подходе под названием Mixture of Experts (MoE), или «Смесь экспертов». Представьте себе не одного всезнайку, а огромный офис, где сидят сотни узкопрофильных специалистов: одни гениально пишут код, другие — мастера поиска информации, третьи — гуру логических рассуждений. Когда к ним поступает задача, некий «менеджер» внутри системы моментально определяет, каких именно экспертов нужно подключить к работе. Остальные в это время, так сказать, пьют кофе и не тратят ресурсы.

И вот тут-то и кроется вся магия. Всего в «компании» MiniMax-M2 трудятся 230 миллиардов «сотрудников» (параметров), но для решения вашего конкретного запроса — будь то написание скрипта или поиск данных — привлекается лишь небольшая команда, около 10 миллиардов. То есть, вместо того чтобы «поднимать на уши» всю гигантскую модель, работает лишь её крошечная, но самая нужная часть. Это и даёт ту самую знаменитую скорость и экономичность, позволяя модели быть одновременно и мощной, как огромный механизм, и на удивление шустрой и доступной.

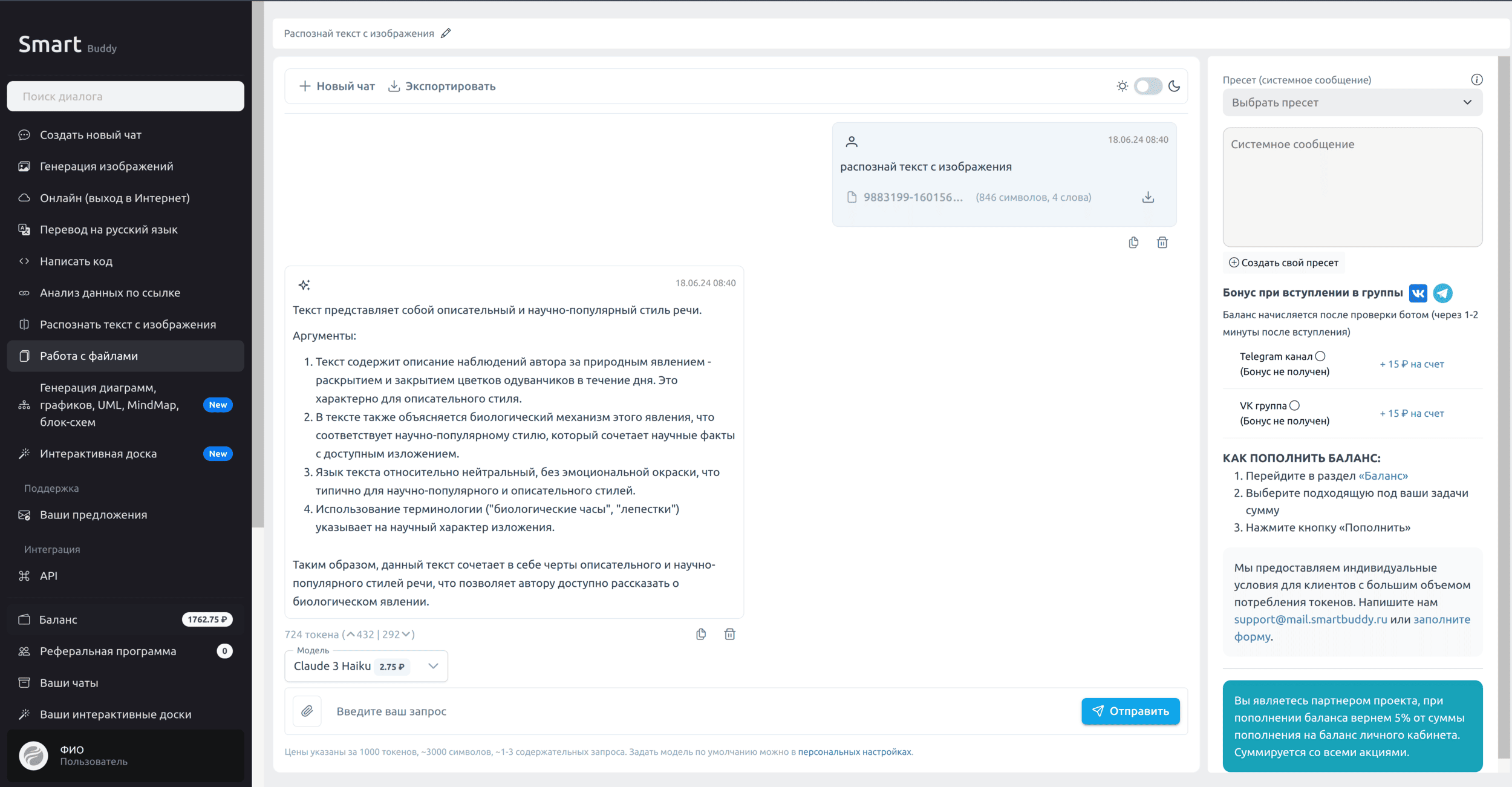

API MiniMax M2.5: доступ и возможности использования в России

Окей, MiniMax-M2.5 — это, конечно, пушка. Но главный вопрос, который возникает у любого разработчика в России: как это всё потрогать, не мучаясь с зарубежными картами и VPN? Именно для этого я и мои коллеги создали SmartBuddy. Мы сами разработчики и знаем, как бесит, когда крутая технология недоступна из-за бюрократии и сложностей с оплатой. Мы просто хотели сделать удобный и честный шлюз к топовым моделям, и, кажется, у нас получилось.

Мы сделали всё, чтобы доступ к API MiniMax был максимально простым и надёжным. Что вы получаете:

- Стабильный доступ к API MiniMax M2.5. Никаких обрывов и лагов.

- Оплата в рублях с любой российской карты. Забудьте про проблемы с зарубежными сервисами.

- Поддержка на русском языке. Если что-то пойдёт не так, мы рядом и поможем.

- Готовые интеграции для ваших любимых инструментов: от IDE (VS Code, JetBrains) и Cursor до n8n, Make.com, BoltAI и даже SillyTavern.

Интеграция элементарная. По сути, вы просто меняете эндпоинт и ключ в своих запросах. Вот рабочий пример, чтобы вы сразу могли попробовать:

curl -X POST https://api.smartbuddy.ru/v1/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer YOUR_API_KEY" \

-d '{

"model": "minimax/minimax-m2.5",

"messages": [

{"role": "user", "content": "Напиши скрипт на Python для парсинга заголовков с главной страницы Hacker News"}

]

}'Всю документацию можно найти тут: https://api.smartbuddy.ru. И да, в качестве приветствия мы накинули небольшой бонус на счёт всем, кто зарегистрируется. Буду рад видеть вас среди пользователей

Команда разработчиков: кто стоит за MiniMax M2.5?

За всей этой технологической мощью, кстати, стоит не очередной гигант вроде Google или OpenAI, а довольно молодой китайский стартап MiniMax. И это, знаете ли, многое объясняет. Они, кажется, задались очень прагматичным вопросом: как сделать ИИ-агентов по-настоящему доступными и рабочими, а не просто игрушкой для гигантских дата-центров? Их цель была не в том, чтобы просто нарастить триллионы параметров, а в том, чтобы создать что-то чертовски эффективное.

Именно эта мотивация и привела их к архитектуре MoE (Mixture of Experts). Дело в том, что вместо того чтобы «включать» всю нейросеть целиком на каждый чих, они задействуют только нужных «специалистов» под конкретную задачу. И вот результат: из 230 миллиардов общих параметров на ваш запрос откликаются всего 10 миллиардов. Это как иметь огромную корпорацию, но для решения вашей проблемы вызывать только релевантный отдел из трёх человек, а не проводить общее собрание. Их фокус очевиден — не просто генерация красивого текста, а создание реальных, рабочих инструментов для кодинга и сложных задач, которые не сожрут все ресурсы вашего сервера.

Будущее MiniMax M2.5: куда движется технология?

Так, с бенчмарками всё понятно — модель действительно мощная. Но, честно говоря, цифры в таблицах не передают главного. Суть MiniMax M2 (и её будущих версий, вроде M2.5) не в том, чтобы просто лучше отвечать на вопросы. Это, по сути, чертёж для создания настоящих ИИ-агентов, которые могут не просто болтать, а выполнять реальную, многоэтапную работу. Похоже, разработчики делают ставку не на размер, а на интеллект и автономность.

И вот тут-то и кроется вся магия. Благодаря архитектуре Mixture of Experts, модель не задействует все свои 230 миллиардов параметров сразу. Она, как опытный менеджер, вызывает только нужных «специалистов» для конкретной задачи. Что это даёт на практике? Представьте себе ассистента, который не просто пишет код по вашему запросу. Он его запускает, видит ошибку, самостоятельно ищет решение в интернете, а потом исправляет свой же код и пробует снова. Это уже не просто помощник, а полноценный цифровой стажёр, способный работать почти автономно.

Короче говоря, будущее MiniMax M2.5 — это мир, где сложные автоматизированные системы станут доступны не только гигантам вроде Google, но и небольшим командам и даже отдельным энтузиастам. Умные и экономичные агенты принесут больше пользы, чем гигантские, но неповоротливые модели. Мы наблюдаем важный сдвиг от «думающих» машин к машинам «делающим», и это может изменить правила игры для всех.