OpenAI: gpt-oss-120b | Чат-бот

Бесплатный доступ к нейросети, без регистрацииДоступ к топовым нейросетям

- ✨ Нет ограничения на количество символов

- ✨ Бонус за регистрацию

- ✨ Все передовые нейросети в одном месте

- ✨ Удобные чат-боты в Telegram и VK

От идеи до реализации: Как появилась GPT-OSS-120b

Выпуск gpt-oss-120b — это, конечно, не просто жест доброй воли. Давайте будем честны: к 2025 году OpenAI, после долгих лет закрытости со времен GPT-2, начала терять очки в глазах сообщества. Появилось множество мощных открытых моделей, и компания рисковала превратиться в «большого закрытого брата», оторванного от реальных нужд разработчиков. По сути, gpt-oss-120b стал их громким ответом. Это был мощный стратегический ход, чтобы доказать: мы всё ещё лидеры, причём не только в закрытом сегменте, но и на поле open-source.

Но дело не только в политике. OpenAI решила ключевую проблему, которая тормозила всё сообщество, — чудовищные требования к «железу». Вместо того чтобы «включать» все 120 миллиардов параметров для каждой задачи, модель, благодаря архитектуре Mixture-of-Experts, задействует лишь крошечную их часть — около 5.1 миллиарда. Вдумайтесь: вся мощь флагманской модели, которая на бенчмарках обходит проприетарные аналоги, умещается на одном-единственном GPU H100! Это не просто «вот вам открытая модель», а «вот вам инструмент, которым вы реально можете пользоваться, а не только читать о нём в статьях». Такой подход демократизировал доступ к самым передовым технологиям, вернув контроль в руки разработчиков.

Что умеет GPT-OSS-120b?

И вот тут начинается самое интересное. Это ведь не просто очередная модель с открытым кодом. Это OpenAI, которые всегда держали свои лучшие разработки под замком, вдруг выкатывают монстра, сопоставимого с их же закрытыми o4-mini. Это реально меняет правила игры. Раньше был вечный компромисс: либо мощь, но в «золотой клетке» API, либо свобода, но с моделями попроще. Теперь этот выбор, кажется, уходит в прошлое.

А весь фокус — в умной архитектуре Mixture-of-Experts. Да, у модели почти 120 миллиардов параметров, но в каждый конкретный момент времени работают «всего» 5.1 миллиарда. Представьте себе огромный штат из 128 специалистов, из которых для решения задачи вызываются только четверо самых подходящих. Добавьте сюда нативную 4-битную квантизацию, и вуаля — вся эта махина помещается на одной-единственной видеокарте H100. Еще пару лет назад запустить модель такого класса без целого серверного кластера казалось фантастикой.

В итоге мы получаем невероятную вещь: полный контроль над моделью флагманского уровня. Можно анализировать гигантские документы в 130 тысяч токенов локально, не отправляя данные на чужие серверы. Можно тонко настраивать модель под свои специфические задачи, будь то медицина или юриспруденция. Это открывает двери для стартапов и исследователей, у которых раньше просто не было доступа к таким мощностям.

Сравнение с конкурентами: Почему выбирают GPT-OSS-120b?

Окей, давайте начистоту. На фоне других открытых моделей, особенно плотных гигантов вроде Llama 3, gpt-oss-120b выглядит как гость из будущего. Вы только вдумайтесь: модель на ~120 миллиардов параметров, которая благодаря 4-битной квантизации и MoE-архитектуре влезает в один-единственный GPU на 80 ГБ. Это же просто космос! Для запуска сопоставимой по общему числу параметров плотной модели вам понадобилась бы целая ферма из нескольких видеокарт. OpenAI здесь, по сути, ломает правила игры, делая по-настоящему крупную модель доступной не только для корпораций с бездонными бюджетами.

Но, как всегда, есть нюансы. С одной стороны, это прямой конкурент таким «народным» MoE-моделям, как Mixtral. Однако gpt-oss-120b предлагает куда более сложную систему с 128 экспертами, из которых работают четыре. Это дает больше гибкости, но и повышает риск, что модель «промахнется» с выбором нужных специалистов для конкретной задачи. Иногда MoE-архитектура может дать ответ не такой глубокий, как у плотной модели, где работают все параметры сразу. А фишка с регулировкой «усилия для рассуждений» — это вообще палка о двух концах. Да, это крутой контроль, но для получения лучшего результата пользователю теперь нужно самому думать, какой режим выбрать, вместо простого «спросил — получил ответ».

Как это работает: Простой разбор архитектуры

Так как же эта махина на 120 миллиардов параметров умудряется работать так шустро и не требовать для себя целого дата-центра? Всё дело в умной архитектуре, которая называется Mixture-of-Experts (MoE). Представьте себе не одного гигантского всезнайку, а огромный совет из 128 узкопрофильных экспертов. Когда вы задаете модели вопрос, она не задействует всю свою мощь сразу. Нет, она умнее. Система быстро определяет, какие именно 4 эксперта из 128 лучше всего разбираются в вашей теме, и передает задачу только им.

Именно поэтому из колоссальных 120 миллиардов параметров в каждый конкретный момент активны «всего» 5.1 миллиарда. Это и есть главный фокус! Но и это еще не все. Чтобы вся эта конструкция поместилась, скажем, на один серверный GPU, разработчики пошли на хитрость — они «сжали» данные с помощью 4-битной квантизации. Это чем-то похоже на то, как вы сжимаете огромную фотографию в компактный JPG-файл, почти не теряя в качестве. В итоге получается невероятное: мощь, сопоставимая с лучшими закрытыми моделями, становится доступной для запуска локально. И это, честно говоря, меняет правила игры.

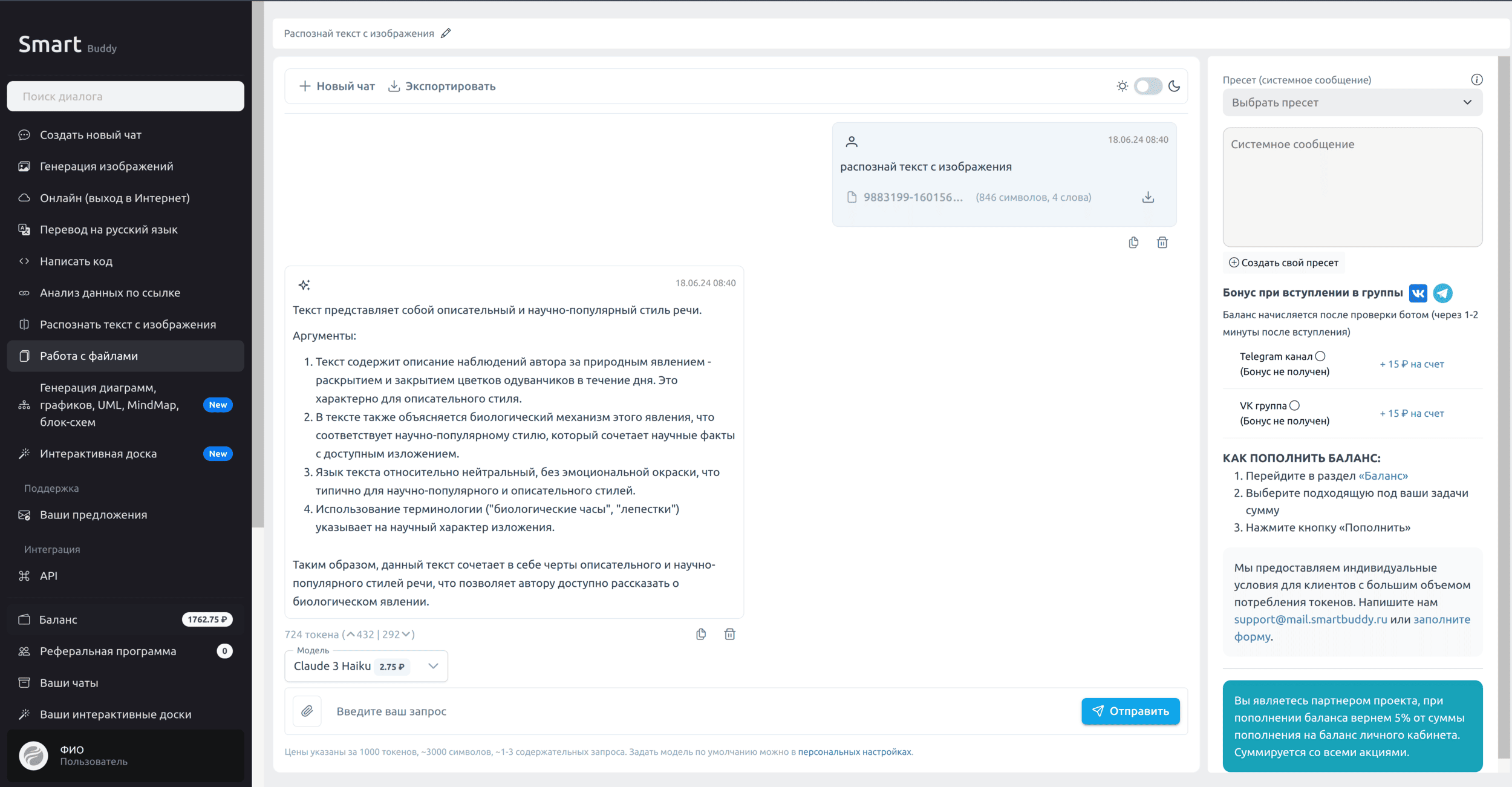

Доступ по API: Как использовать GPT-OSS-120b в России

Когда я впервые услышал о gpt-oss-120b, я, как и многие из вас, был в восторге. Наконец-то мощная открытая модель от OpenAI! Но потом пришло осознание: чтобы запустить этого зверя, нужен как минимум H100, а это, мягко говоря, не у всех под рукой. Да, модель открытая, но давайте честно — самостоятельная поддержка такой инфраструктуры это та ещё головная боль. Именно поэтому мы в SmartBuddy решили эту проблему раз и навсегда, предоставив стабильный и быстрый доступ к gpt-oss-120b через наше API.

Мы сделали всё, чтобы вам, разработчикам, было максимально удобно. Забудьте про сложности с иностранными сервисами и картами. У нас всё просто:

- Удобная оплата в рублях с любых российских карт. Никаких VPN и зарубежных счетов.

- Техподдержка на русском языке, которая реально помогает, а не отвечает скриптами.

- Готовые интеграции с кучей инструментов: от IDE и Cursor до n8n, SillyTavern и Make.com. Чтобы вы не тратили время на «велосипеды».

Интеграция и правда простая, вот рабочий пример curl-запроса. Просто замените YOUR_SMARTBUDDY_API_KEY на свой ключ, и всё полетит.

curl https://api.smartbuddy.ru/v1/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer YOUR_SMARTBUDDY_API_KEY" \

-d '{

"model": "openai/gpt-oss-120b",

"messages": [

{

"role": "user",

"content": "Расскажи, в чем главная фишка архитектуры Mixture-of-Experts?"

}

]

}'Кстати, для всех новых пользователей мы приготовили небольшой приветственный бонус на счёт сразу после регистрации. Вся документация лежит здесь: https://api.smartbuddy.ru. Буду рад видеть вас среди наших пользователей

Будущее нейросетей: Что дальше для GPT-OSS-120b?

Ну что тут сказать, появление gpt-oss-120b — это настоящая бомба. OpenAI, годами бывшая синонимом «закрытых» технологий, вдруг делает такой щедрый подарок всему сообществу. Это полностью переворачивает игру. Теперь любая компания, даже небольшой стартап, может взять эту махину и дообучить её на своих данных, не отправляя ничего в облако. Представьте: свой собственный, полностью контролируемый аналог GPT-4 для анализа внутренних документов, будь то медицинские записи или финансовые отчеты. Больше не нужно зависеть от чужих API и молиться, чтобы они не упали в самый ответственный момент. Это даёт невероятный уровень свободы и безопасности.

И это ведь только начало. Я почти уверен, что в ближайший год мы увидим, как на базе gpt-oss-120b, словно грибы после дождя, начнут расти десятки узкоспециализированных моделей. Кто-то сделает из нее гениального юридического помощника, кто-то — эксперта по генерации кода на редких языках. Сама архитектура с её режимами рассуждения (LOW, MEDIUM, HIGH) буквально кричит: «Настройте меня!». А учитывая, что в основе заложена мультимодальность, сообщество наверняка скоро «прикрутит» к ней зрение и слух. Мы получили не просто готовую модель, а мощнейший конструктор, из которого будут собирать будущее ИИ в ближайшие пару лет.

OpenAI: Люди за моделью

Честно говоря, анонс GPT-OSS-120b стал для многих громом среди ясного неба. Ведь OpenAI, которая начинала с открытости, в последние годы, казалось, напрочь забыла о своих корнях. Все мы помним, как GPT-2 была последней «свободной» ласточкой, а потом — тишина и сплошные проприетарные гиганты, доступ к которым строго контролировался. Так что же изменилось? Похоже, в компании решили, что пора вернуться к своей изначальной миссии — делать ИИ доступным для всех, а не только для тех, кто может платить за API.

Но, конечно, дело не только в чистой философии. Рынок open-source моделей буквально взорвался за последние пару лет. Появились мощные игроки вроде Llama 3 и Mistral, и игнорировать этот тренд стало просто невозможно. Мне кажется, в OpenAI поняли: либо ты участвуешь в открытой гонке и остаешься релевантным для огромного сообщества разработчиков, либо рискуешь остаться в своей «золотой клетке» в стороне от бурно развивающейся экосистемы. GPT-OSS — это не просто подарок, это их мощный стратегический ответ, чтобы доказать, что они все еще могут задавать тон в мире открытых LLM.