Llama 4 Maverick | Чат-бот

Бесплатный доступ к нейросети, без регистрацииДоступ к топовым нейросетям

- ✨ Нет ограничения на количество символов

- ✨ Бонус за регистрацию

- ✨ Все передовые нейросети в одном месте

- ✨ Удобные чат-боты в Telegram и VK

История создания: Как родилась Llama 4 Maverick?

Появление Llama 4 Maverick — это, по сути, ответ Meta* на сумасшедшую гонку вооружений в мире ИИ. Знаете, когда GPT-4 и Gemini задали невероятно высокую планку, главный вопрос, который витал в воздухе, был таким: как сделать модель умнее, не делая её неподъёмно дорогой и медленной? Компания решила не идти в лоб, просто наращивая мускулы, а сыграть хитрее. Их основная идея — эффективность. Они хотели создать флагмана, который мог бы конкурировать с лучшими, но при этом не требовал бы для работы целого парка электростанций.

И вот тут на сцену выходит их главная фишка — архитектура Mixture of Experts (MoE). Представьте себе не одного гигантского «мозга», который пытается знать всё, а целую команду из 128 узких специалистов. Когда приходит задача, специальный «диспетчер» решает, каких именно экспертов позвать на помощь. В итоге из 400 миллиардов общих параметров в каждый конкретный момент работает всего около 17 миллиардов. Хитро, правда? Это позволило им решить сразу две проблемы: добиться высочайшей производительности в сложных задачах вроде кодинга и логики, и одновременно сделать модель относительно «лёгкой» в использовании.

Более того, чтобы «воспитать» Maverick, они использовали знания от ещё более колоссальной, внутренней модели Llama 4 Behemoth с двумя триллионами параметров. Это похоже на то, как опытный гроссмейстер обучает талантливого мастера, передавая ему не просто знания, а интуицию и глубину понимания. Такой подход позволил Maverick стать мощным инструментом для анализа огромных объёмов данных — вплоть до 10 миллионов токенов, — решая проблемы, которые раньше казались просто неподъёмными.

Что умеет Llama 4 Maverick: Уникальные способности модели

Давайте разберемся, что такого особенного в Llama 4 Maverick, ведь фишек у нее хватает. Главная бомба — это, конечно, контекстное окно в 10 миллионов токенов. Вы только вдумайтесь! Это же можно загрузить в нее целый роман, вроде «Войны и мира», а потом детально обсуждать сюжетные линии второстепенных персонажей. И да, она не только читает, но и «видит» — обработка изображений тоже в комплекте, что делает её по-настоящему мультимодальной.

Ещё одна крутая вещь — многоязычность. Maverick говорит на 200 языках, что открывает двери для глобальных проектов. Но самое интересное кроется в её архитектуре Mixture of Experts. По сути, это не просто одна большая голова, а целый «консилиум» из 128 узкоспециализированных «экспертов». Когда вы задаете вопрос, система сама решает, какого специалиста подключить: один шарит в коде, другой — в анализе медицинских данных, третий — в юридических документах. Это делает её чертовски эффективной, ведь задействуются только нужные 17 миллиардов параметров из общих 400.

Сравнение с конкурентами: Почему Maverick может стать вашим фаворитом?

И вот тут начинается самое интересное — прямое столкновение с гигантами вроде GPT-4 и Gemini 2. Да, на бумаге Llama 4 Maverick выглядит монстром, сопоставимым с GPT-4.5 по некоторым метрикам. Но дьявол, как всегда, в деталях. Главный, и не самый очевидный, козырь Maverick — это не просто 400 миллиардов параметров, а потрясающая эффективность архитектуры MoE. То есть, для её работы нужен всего один сервер с 8 GPU H100. Это, знаете ли, делает топовые технологии гораздо доступнее, в то время как истинная стоимость запуска GPT-4 остаётся коммерческой тайной OpenAI.

Но у этой эффективности есть и обратная сторона, о которой не кричат в пресс-релизах. Архитектура «смеси экспертов» иногда даёт сбой. Маршрутизатор может отправить ваш сложный запрос «не тому специалисту», и в итоге вы получаете нерабочий код или странные логические петли. Честно говоря, это расстраивает. GPT-4, в свою очередь, ошибается реже, он более стабилен, что ли. А Gemini 2.5 Pro, хоть и не всегда дотягивает в чистой логике, берёт своё за счёт изначально глубокой мультимодальности — он думает картинками и текстом одновременно, а не по очереди, как многие другие. Так что выбор сводится к дилемме: доступная мощь с сюрпризами (Llama), надёжный золотой стандарт (GPT) или мультимодальный специалист (Gemini).

Архитектура, объясненная просто: Как работает Llama 4 Maverick?

Так как же устроена эта нашумевшая архитектура Mixture of Experts (MoE)? Проще говоря, забудьте про идею одной гигантской нейросети, которая пытается знать всё на свете. Представьте себе не одного всезнайку, а большой совет экспертов. Ну, знаете, как в крупной компании: есть специалист по финансам, есть юрист, а есть программист. Над ними стоит своего рода «диспетчер» (gating network), который, получив задачу, решает: «Так, это вопрос по коду — отправлю-ка я его к нашим программистам».

И вот тут-то и начинается магия. Вы просите Llama 4 написать сложный алгоритм — диспетчер стучится к нескольким «экспертам» по кодированию в этом совете. Задаете вопрос по истории Древнего Рима — в дело вступают «историки». Причем для решения одной задачи могут быть задействованы сразу несколько экспертов, если она требует, скажем, и логики, и креативности одновременно.

В случае с Llama 4 Maverick этот «совет» просто огромен — целых 128 экспертных подсетей! Но самое главное, что для ответа модель не напрягает всех 128. Нет! Она активирует лишь небольшую, самую подходящую часть. Именно поэтому, имея гигантские 400 миллиардов общих параметров, в каждый конкретный момент работают «всего» 17 миллиардов. Это делает модель и мощной, и на удивление эффективной, ведь она не тратит ресурсы впустую.

Доступ по API: Как использовать Llama 4 Maverick в России?

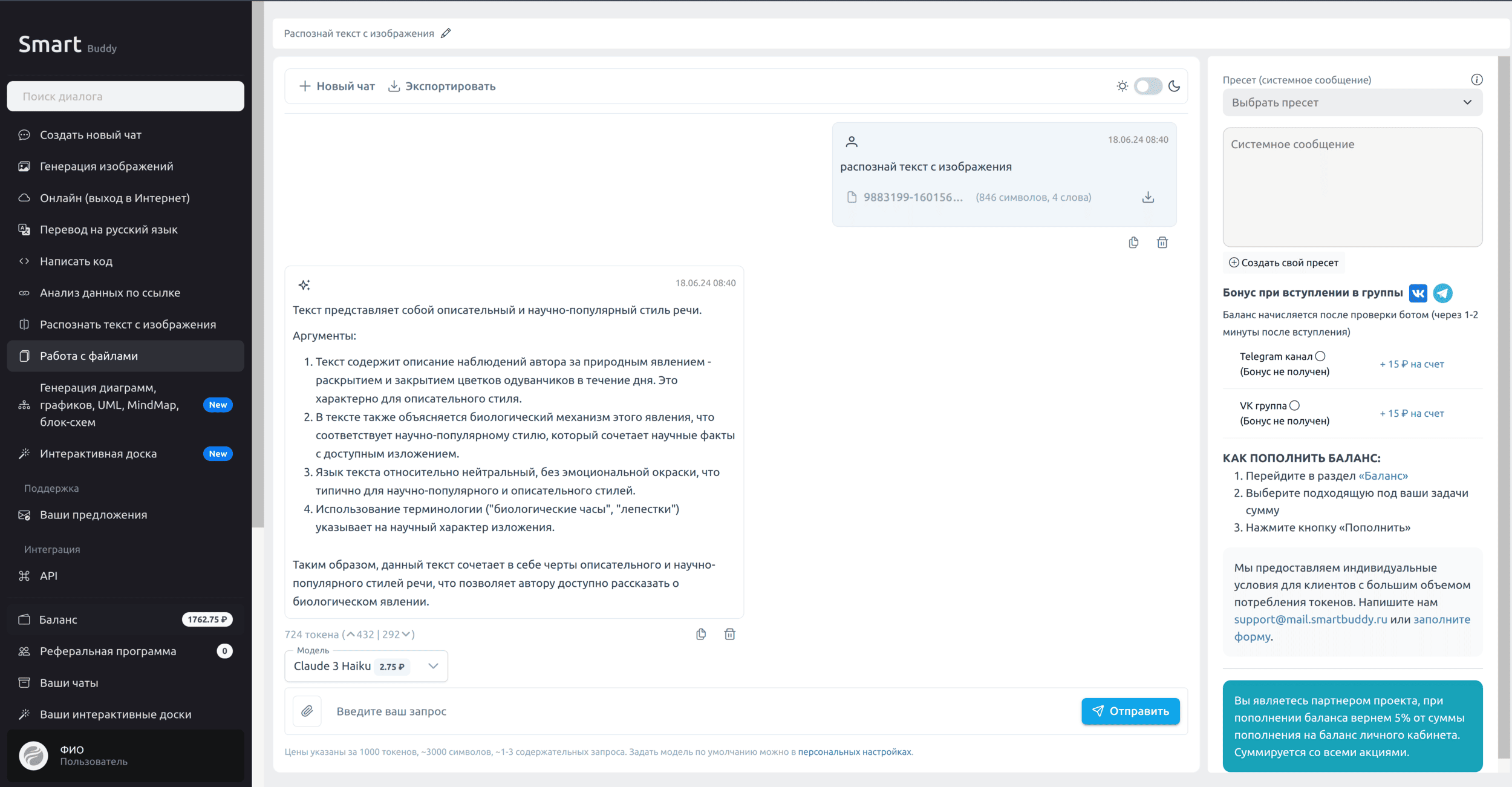

Когда Llama 4 Maverick только появилась, мы, как и все, загорелись идеей её потестировать. Но, честно говоря, сразу столкнулись с классической проблемой: как получить к ней удобный и, главное, стабильный доступ из России? Именно для этого мы и создали SmartBuddy. Я сам разработчик, и мне хотелось сделать сервис, который решает головную боль, а не создаёт новую. Мы постарались убрать все барьеры, чтобы вы могли просто взять и начать работать с топовой моделью.

Под капотом у SmartBuddy всё заточено под простоту и удобство, особенно для наших ребят. Вот что мы предлагаем:

- Стабильный API для Llama 4 Maverick. Просто работает.

- Оплата в рублях с любой российской карты. Больше не нужно заморачиваться с зарубежными счетами или криптой.

- Поддержка на русском языке. Если что-то пойдёт не так, мы рядом и говорим на одном языке.

- Готовые интеграции с инструментами, которые вы, скорее всего, уже используете: IDE, Cursor, n8n, Make.com, SillyTavern и другие.

Начать проще простого. По сути, вы просто меняете эндпоинт в своих запросах. Всё, как дважды два:

curl -X POST "https://api.smartbuddy.ru/v1/chat/completions" \

-H "Content-Type: application/json" \

-H "Authorization: Bearer YOUR_SMARTBUDDY_API_KEY" \

-d '{

"model": "meta-llama/llama-4-maverick",

"messages": [

{"role": "user", "content": "Привет! Расскажи анекдот про программиста."}

]

}'Всю документацию мы аккуратно собрали здесь: https://api.smartbuddy.ru. И, конечно, чтобы вам было приятнее начать, мы приготовили небольшой приветственный бонус для всех новых пользователей. Заходите, будем рады

Разработчики модели: Кто стоит за Llama 4 Maverick?

А давайте-ка на секунду представим себя в Meta*. Ты видишь, как OpenAI и Google выкатывают всё новые и новые закрытые модели, а рынок гудит от предвкушения. Что делать? Сидеть сложа руки? Конечно, нет. У компании ведь есть свой главный козырь — открытое сообщество и философия open-source. Llama 4 Maverick — это не просто очередная нейросеть. Это их флагман, их главная ставка в этой технологической гонке, которой они как бы говорят: «Вот вам самый мощный инструмент, который мы можем дать бесплатно. Развивайте его, используйте, покажите, на что он способен».

И дело тут не только в амбициях. Maverick — это ещё и демонстрация очень умной инженерной мысли. Вместо того чтобы просто наращивать мускулы и создавать гигантского, неповоротливого монстра, они пошли по хитрому пути. Архитектура Mixture of Experts (MoE) — это как иметь команду из 128 узких специалистов. Зачем дёргать всех сразу, если для конкретной задачи нужен только «математик» и «лингвист»? Именно поэтому из 400 миллиардов параметров в любой момент активны всего 17 миллиардов. Это колоссальная экономия ресурсов! Плюс сумасшедшее контекстное окно в 10 миллионов токенов. Это уже не просто болталка, а инструмент для анализа целых книг или огромных баз кода за один присест.

Будущее нейросетей: Как Llama 4 Maverick меняет правила игры?

Давайте начистоту, дело тут не в очередном «убийце GPT». Важнее то, что Llama 4 Maverick делает возможным в принципе. Только вдумайтесь: контекстное окно в 10 миллионов токенов! Это не просто чат-бот, который «помнит» разговор чуть дольше. Это возможность скормить нейросети целую научную работу, огромный юридический договор или всю базу кода проекта за один раз. Раньше для подобного анализа требовались десятки запросов и сложные «костыли», а теперь Maverick может увидеть всю картину целиком.

И вот тут-то открывается самое интересное. Добавьте к этому поддержку 200 языков и мультимодальность. На выходе мы получаем не просто умного собеседника, а полноценного цифрового ассистента для сложных задач. Он может, к примеру, проанализировать техническую документацию на немецком с чертежами и тут же сгенерировать по ней обучающие материалы для команды в Бразилии. А благодаря архитектуре Mixture of Experts (MoE), где в каждый момент активны «всего» 17 из 400 миллиардов параметров, такая мощь становится доступной не только IT-гигантам. По сути, Meta* делает шаг к тому, чтобы сложные, комплексные ИИ-решения стали рабочим инструментом для среднего бизнеса, научных групп и даже отдельных энтузиастов.