MiniMax M2.1 | Чат-бот

Бесплатный доступ к нейросети, без регистрацииДоступ к топовым нейросетям

- ✨ Нет ограничения на количество символов

- ✨ Бонус за регистрацию

- ✨ Все передовые нейросети в одном месте

- ✨ Удобные чат-боты в Telegram и VK

От идеи до реализации: история MiniMax M2.1

Давайте представим, с чего всё начиналось. Наверняка, команда MiniMax посмотрела на рынок и сказала: «Так, у нас есть гиганты вроде GPT-4, которые стоят как крыло самолёта, и есть открытые модели, которым часто не хватает „зубов“ для реальных задач». Эта дилемма — мощь против доступности — и стала, по сути, отправной точкой. Нужно было создать что-то, что не заставит разработчиков выбирать между кошельком и качеством, особенно в сложных агентных сценариях, где цена ошибки (и вычислений) высока.

И вот тут-то и появляется гениальная в своей простоте идея — архитектура MoE. Вместо того чтобы «включать» все 230 миллиардов параметров для каждой задачи, M2.1 активирует лишь небольшую, нужную в данный момент часть — около 10 миллиардов. По сути, это как если бы мозг использовал только специализированные отделы для конкретной работы, не задействуя всю свою массу. Это решение позволило не просто гнаться за цифрами в бенчмарках, а создать настоящую «рабочую лошадку»: быструю, недорогую и заточенную под реальные проблемы программистов и инженеров.

Суперсилы MiniMax M2.1: что она может?

Знаете, что обычно немного напрягает в мире больших языковых моделей? Вечный компромисс: либо ты получаешь мощь, но по цене крыла самолёта, либо выбираешь что-то доступное, но с заметными ограничениями. И вот тут на сцену выходит MiniMax M2.1 и, кажется, ломает эту систему. Вся фишка в её архитектуре MoE (смесь экспертов), где из 230 миллиардов параметров в каждый конкретный момент работает лишь малая часть — около 10 миллиардов. Это как иметь огромную библиотеку, но мгновенно находить нужную полку, не перелистывая все книги подряд.

Что это значит на практике? А то, что вы получаете производительность, которая в задачах по написанию и исправлению кода (бенчмарк SWE-Bench) или работе в браузере (BrowseComp) почти не уступает топовым закрытым моделям, но платите за это в разы меньше. Цифры говорят сами за себя: цена за API примерно в восемь раз ниже, чем у Claude Sonnet 4.5 при схожем качестве. По сути, MiniMax M2.1 делает мощные ИИ-инструменты доступными не только для корпораций с бездонными бюджетами, но и для небольших команд и даже одиночных разработчиков. И это, честно говоря, меняет правила игры.

Сравнение с конкурентами: почему MiniMax M2.1 лучше?

Давайте начистоту: сравнивать MiniMax M2.1 с гигантами вроде GPT-4 или Claude Opus — это первое, что приходит в голову. И да, результаты на бенчмарках впечатляют, особенно для открытой модели. Но настоящая магия M2.1 кроется не столько в голых цифрах, сколько в том, что она делает возможным для обычных разработчиков и небольших команд. Это не просто «еще одна мощная нейросеть», это настоящий инструмент, который можно взять и использовать прямо сейчас, не продавая почку.

Посудите сами. Модель, которая в ряде задач дышит в спину Claude Sonnet 4.5, стоит в восемь раз дешевле. Восемь! Это означает, что стартап или даже разработчик-одиночка может позволить себе встроить в свой продукт ИИ-агента, который раньше был доступен только корпорациям с гигантскими бюджетами. А вишенка на торте — возможность скачать модель с Hugging Face и запустить локально. Это дает беспрецедентный уровень контроля и кастомизации.

В итоге мы получаем не просто очередного рекордсмена в синтетических тестах, а рабочую лошадку. MiniMax M2.1 делает ставку на практичность: она достаточно умна для сложных задач, достаточно быстра для реального времени и, что самое главное, достаточно доступна, чтобы с ней мог работать каждый. Это меняет правила игры, смещая фокус с «посмотрите, какую умную модель мы создали» на «посмотрите, какие крутые вещи вы можете с ней создать».

Как это работает: архитектура MiniMax M2.1 простыми словами

Так, давайте разберемся с этой магией цифр: 230 миллиардов параметров, но активно всего 10? Звучит как-то странно, но на самом деле все логично. Представьте себе огромную команду экспертов. Вместо того чтобы на каждую, даже самую простую задачу, сгонять весь 230-тысячный коллектив, модель M2.1 поступает как умный руководитель. Она мгновенно определяет суть вопроса и вызывает небольшую, но идеально подходящую команду из 10 «специалистов». Нужно написать код для iOS? Вызываются эксперты по Swift и Objective-C. А нужно проанализировать текст на русском? — подключаются «лингвисты». Остальные в это время, так сказать, отдыхают, не тратя ресурсы.

И вот тут-то и кроется вся соль. Такой подход, известный как MoE (Mixture of Experts), делает M2.1 невероятно шустрой и, что немаловажно, дешёвой. Зачем гонять всю гигантскую махину, если с задачей справится маленькая, но профильная группа? Это ведь прямая экономия на вычислительных мощностях и, как следствие, на стоимости для нас, пользователей. Именно поэтому она умудряется быть примерно в восемь раз дешевле, чем Claude Sonnet 4.5, при этом показывая очень близкие результаты. Честно говоря, для разработчиков и бизнеса это просто подарок — получить такую мощь без необходимости закладывать в бюджет целое состояние.

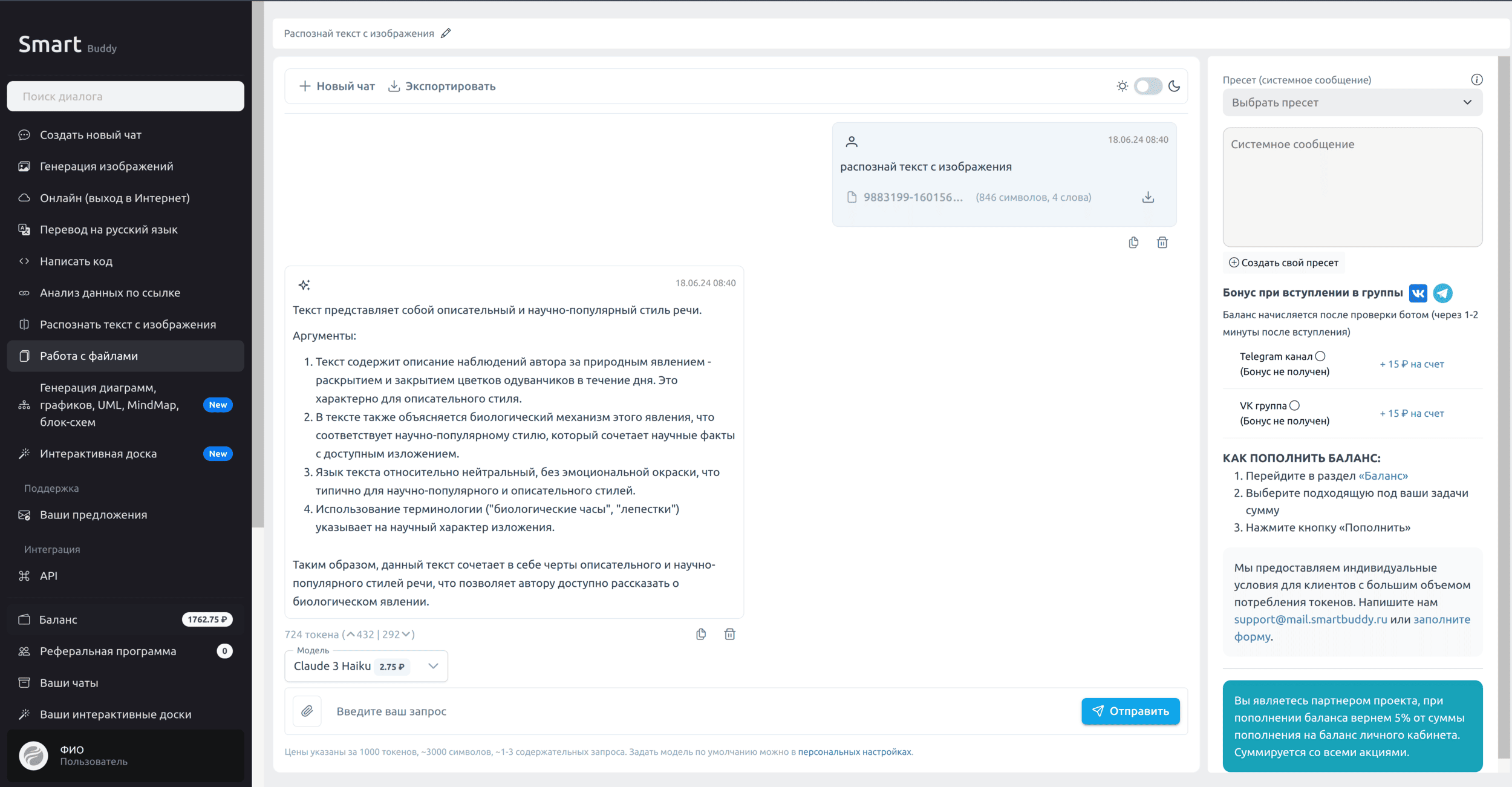

API MiniMax M2.1: доступ для разработчиков в России

Когда я увидел, на что способна MiniMax M2.1, особенно в задачах кодинга и как агент, я сразу понял — это надо дать в руки нашим разработчикам. Но, как всегда, встает вопрос: как получить стабильный доступ из России, да еще и платить удобно, без танцев с бубном и зарубежными картами? Именно для этого мы с командой и создали SmartBuddy. Мы хотели сделать так, чтобы любой разработчик мог без головной боли взять и начать использовать топовые модели в своих проектах.

Мы постарались убрать все барьеры. Вот что вы получаете, работая с MiniMax M2.1 через нас:

- Стабильный и быстрый API-шлюз. Мы сами следим за доступностью и скоростью.

- Оплата в рублях любыми российскими картами. Никаких SWIFT-переводов и крипты.

- Техподдержка на русском языке, которая реально помогает, а не отвечает скриптами.

- Готовые интеграции с кучей инструментов: от IDE и Cursor до n8n, Make.com, BoltAI и SillyTavern.

Подключиться проще простого. По сути, вы просто меняете эндпоинт и модель в своих запросах. Вся документация лежит здесь: https://api.smartbuddy.ru. Вот как выглядит базовый запрос к модели:

curl -X POST "https://api.smartbuddy.ru/v1/chat/completions" \

-H "Content-Type: application/json" \

-H "Authorization: Bearer YOUR_SMARTBUDDY_API_KEY" \

-d '{

"model": "minimax/minimax-m2.1",

"messages": [{"role": "user", "content": "Напиши простой Python-скрипт для парсинга погоды с сайта."}]

}'Мы очень рады новым пользователям, поэтому в качестве небольшого приветствия дарим каждому бонус на счёт сразу после регистрации. Заходите, пробуйте, создавайте крутые вещи! Уверен, вам понравится.

Миссия и команда MiniMax: кто стоит за моделью?

А кто вообще такие эти MiniMax? На фоне общей гонки за триллионами параметров и званием «самой большой модели» их подход выглядит свежо и, я бы сказал, чертовски прагматично. Кажется, их главная идея отражена в самом названии: максимум результата при минимуме затрат. Они не пытаются построить всезнающий цифровой «мозг», а целенаправленно создают эффективный инструмент для реальных задач, доступный не только гигантам вроде Google или Microsoft. Прагматизм в чистом виде.

Именно эта философия и привела к рождению M2.1. Подумайте сами: вместо того чтобы держать в активной памяти гигантскую и неповоротливую модель, они использовали умную архитектуру MoE. Это как иметь доступ к огромной библиотеке на 230 миллиардов «книг» (параметров), но для ответа на конкретный вопрос вызывать только нужного эксперта с его 10 миллиардами знаний. В результате — бешеная скорость, низкая задержка и, что самое главное, вменяемая цена.

И вот это, я считаю, меняет правила игры. Ведь что получается? Мощный ИИ, способный не просто болтать, а реально работать с кодом, файлами и браузером, перестаёт быть игрушкой для корпораций с бездонными бюджетами. Когда твоя модель в восемь раз дешевле аналогов вроде Claude Sonnet 4.5 при схожей производительности, это уже не просто технологическая новинка. Это, по сути, демократизация. MiniMax как бы говорят нам: «Хватит гоняться за цифрами, давайте делать полезные и доступные инструменты». И, честно говоря, такой подход внушает уважение.

Будущее MiniMax M2.1: куда движется технология?

Так что же дальше для MiniMax M2.1? И вот тут начинается самое интересное. Низкая стоимость API — это не просто приятный бонус, это, по сути, меняет правила игры. Представьте себе: небольшая команда инди-разработчиков или даже один энтузиаст теперь может создать сложнейшего ИИ-агента, который раньше был по карману только гигантам вроде Google. Когда цена за обработку миллиона токенов в восемь раз ниже, чем у конкурентов со схожим качеством, это открывает двери для тысяч новых проектов, которые раньше были просто нерентабельны. Просто вдумайтесь.

Но дело не только в цене. Будущее M2.1 — это, конечно, автономные агенты, которые выходят за рамки простого написания кода. Благодаря «размышлениям вслух» и способности работать с терминалом и файлами, мы говорим о помощниках, способных на полный цикл разработки. Например, агент, который не просто пишет код для Android-приложения, а самостоятельно:

- Запускает сборку проекта.

- Тестирует его в эмуляторе.

- Анализирует UI на предмет ошибок.

- И, найдя баг, сам же его исправляет и отправляет pull request. Это уже не фантастика, а вполне реальная перспектива на ближайший год-два, и MiniMax M2.1 выглядит как идеальный кандидат на эту роль.